前回まで4回にわたって、AIの概要と、3度にわたるIAIブームについて解説してきました。

盛衰を繰り返してきた人工知能は、可能性だけでなく様々な問題も孕んでいます。今回はAI・人工知能の諸問題を紹介しています。

トイ・プロブレム

第1次AIブームにおける推論と探索のアプローチのように、本質を損なわないようにしつつ問題を簡略化して考えることをトイ・プロブレム(おもちゃの問題)と呼びます。当初は、ルールとゴールが明確になっている問題をAIが解けるという文脈でしたが、AIがトイ・プロブレムしか解くことができず、現実の問題に対応できないと認識されるようになってからは、ネガティブなニュアンスを含むようになりました。

フレーム問題

フレーム問題とは、1969年にジョン・マッカーシーとパトリック・ヘイズが提唱した問題で、人工知能は限られた処理能力しか有さず、目の前の問題に関係することだけを考えるのが難しい、といった内容です。名前の由来は、人工知能は世の中のすべての物事について考慮すると時間がかかり過ぎてしまうために、枠を作ってその枠(フレーム)の中だけで考えてしまう、というものです。人間でもフレーム問題が発生することはありますが、特に人工知能においては著しい問題となりえます。

哲学者のダニエル・デネットが1984年に著書で解説した爆弾とロボットの問題が有名ですので、簡単に説明します。洞窟の中にロボットを動かすためのバッテリーがあり、それを取ってくるように指示されていますが、その上には時限爆弾が設置されています。この時、人間であれば”まず時限爆弾を外してからバッテリーを持ち出す”ことを自然に思いつくはずです。しかしロボットの場合は、”時限爆弾に気づかない“、”気づいたとしても、爆発させないための方法がわからない“、”爆発させないための方法を計算するのに時間がかかりすぎる“などの理由で、バッテリーを持ち出すことができない、というものです。

フレーム問題は、機械学習・ディープラーニングが登場した後も本質的な解決をしておらず、人工知能分野の最大の難問とも呼ばれています。

“強いAI”は存在しうるのか?

AIとは何かという記事でも書いた通り、強いAIというのは、心や精神を持ったコンピュータです。

強いAIが存在しうるのか、また存在するとしてそれをどのように判定するのか、といった観点でこれまで様々な議論が巻き起こっています。

チューリングテスト

チューリングテスト(Turing test)は、イギリスの数学者アラン・チューリングが1950年に考案した人工知能の性能を確かめるためのテストの方法です。人間の知的活動と同等の活動をAIに実施させて、判定者にそれが人間なのかAIなのかを当ててもらいます。

判定者の30%以上がAIが人間と判断した場合に、AIには”知能がある”とされますが、未だにチューリングテストを合格するAIは現れていません。

チューリングテストの発想はつまり、AIが知能を持っているかどうかをその構造から決めるのが難しく、外部の観察によって判断せざるを得ない、ということです。

ロブナー賞

ロブナー(Loebner)賞はチューリングテストを合格するチャットボットを開発するコンテストで、1991年以降毎年開催されています。

中国語の部屋

中国語の部屋というのは、ジョン・サールの論文中に出てくるチューリングテストへの反論の代表例とされる思考実験です。”中国語の部屋”では中国語のわからない人を部屋に閉じ込めて、中国語の紙切れ(入力)に書かれた内容をマニュアルに沿って対応させて中国語を追記して紙切れを返す(出力)するだけでも、チューリングテストを合格しうるが、これは中の人が中国語を理解したことにならない、といった内容です。

つまりこれは、AIが人間のような対応をしたとしても、それが人間と同じような知能を持っていることにはならない、という主張なのです。

ペンローズの量子脳理論

2020年のノーベル物理学賞受賞者であるロジャー・ペンローズはその著書『皇帝の新しい心』の中で、脳のふるまいを量子力学的な視点から説明しています。

それによれば、意識はニューロンを単位をして生じるのではなく、超ミクロな物理現象である量子効果が及ぼされる微小管から生じます。従い、現在のコンピュータの構造では、精神を持った強いAIは実現不可能だとされています。

現在の人工知能が人間のニューロンを模した構造を利用していることについては、今後”ディープラーニング”に関する記事を執筆する予定ですので、そちらをお待ちください。

シンボルクラウンディング(記号接地問題)

シンボルクラウンディング(Synbol Grounding)問題とは、強いAIを実現するためには、記号をAIがどう認識するかということが問題になる、ということです。認知科学者のスティーブン・ハルナッドにより定義されました。

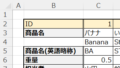

人間は”リンゴ”と言われれば赤い色や手触りや味を想像できます。また人間が”シマウマ“という言葉を聞けば、実物を見たことがなくとも、“縞”と”馬”の概念を知っているため想像することができ、結果的に初めてシマウマを見た場合でも認識することができます。これを、グランディングする(結びつける)ことができる、と言います。

しかしAIの場合には、これらは単なるカタカナの塊でしかないため、グランディングすることができないのです。上述のフレーム問題とは異なり、シンボルグラウンディング問題は人間には起きません。

このシンボルグラウンディング問題に対し、身体がないと解決できないと考えるのが身体性のアプローチです。

知能と身体性の関係

人間は身体を通して様々な情報を受け取っています。目の前にリンゴがあるとき、実際に手に取ってみて、その大きさや重さ、形、手触りという大量のデータが入ってきて、それらがリンゴの概念を形成していきます。

同じように、知能が成立するには身体性が必要だと考え、身体性の観点から人工知能にアプローチするという考え方があり、研究が進んでいます。

知識獲得のボトルネック

第2次AIブームの記事の中で説明していますので、ご一読ください。

凍結された東ロボくん

東ロボくんというのは、2011年に開始され東大合格を目指して研究・開発された人工知能のプロジェクト名称、及びその人工知能の名前です。

東ロボくんは2016年時点でMARCH(明治、青山、立教、中央、法政)と言われる東京の有名私立大学に合格できるレベルにまで達していましたが、その実態は大量の暗記によって”理解している風”を装っているだけで、結局”意味を理解する”ということができず、東大合格は断念されました。

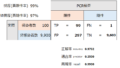

その後も記述式試験の研究などは進められており、2019年にはセンター試験の英語で偏差値64.1を記録したということです(185/200点)。

シンギュラリティー

現状における人工知能の最大の問題が、この”シンギュラリティー(Singularity)”かもしれません。シンギュラリティーというのは、日本語訳では特異点で、元々は物理学の用語です。ある基準が適応できなくなる点という意味で、重力についてのルールが適応できなくなる特異点であるブラックホールが最もよく知られた例であると思います。

人工知能の場合には、カーツワイル博士がシンギュラリティーという言葉を広めました。人工知能の改良が進んだ先に、人間の知能を凌駕し、それ故にその後の人工知能がどのように変化していくのかが全く予想できなくなる状況を示唆します。

シンギュラリティー懐疑論

シンギュラリティーが人類の将来を脅かすものであるという意見がある一方で、シンギュラリティーについて懐疑的な意見も存在します。上述の東ロボくんのように、結局人工知能は意味を理解することはできないという前提に立てば、人工知能が人間の知能を超えるのは難しいのかもしれません。

コメント