AI/データサイエンス

AI/データサイエンス 【ディープラーニング】ChatGPTの”GPT”とは何か? – Generative Pretrained Transformer

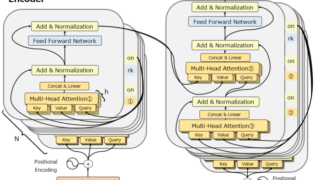

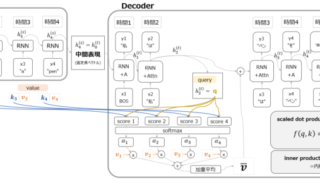

GPT(Generative Pretrained Transforme)はOpenAIが2018年に公開した自然言語処理(NLP)のモデルです。GPTは事前学習済のTransformerベースのモデルで、ファインチューニングすることで生成タスクに用いることができます。

AI/データサイエンス

AI/データサイエンス  AI/データサイエンス

AI/データサイエンス  AI/データサイエンス

AI/データサイエンス  AI/データサイエンス

AI/データサイエンス  AI/データサイエンス

AI/データサイエンス  AI/データサイエンス

AI/データサイエンス  AI/データサイエンス

AI/データサイエンス