AI/データサイエンス

AI/データサイエンス 【機械学習】バッチ学習とオンライン学習 – バッチ勾配降下法と確率的勾配降下法の違いは何か?

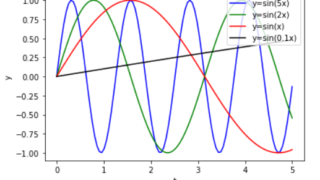

過去の記事で勾配降下法について解説しました。今回は、バッチ学習とオンライン学習を説明した上で、確率的勾配降下法、バッチ勾配降下法、ミニバッチ勾配降下法を解説し、さらに関連事項としてバッチ正規化についても説明します。

AI/データサイエンス

AI/データサイエンス  AI/データサイエンス

AI/データサイエンス  AI/データサイエンス

AI/データサイエンス  AI/データサイエンス

AI/データサイエンス  AI/データサイエンス

AI/データサイエンス  AI/データサイエンス

AI/データサイエンス  AI/データサイエンス

AI/データサイエンス  AI/データサイエンス

AI/データサイエンス  AI/データサイエンス

AI/データサイエンス  AI/データサイエンス

AI/データサイエンス