AI/データサイエンス

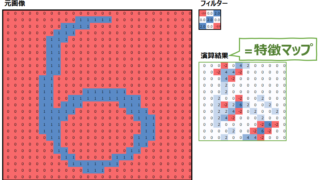

AI/データサイエンス 【畳み込み/CNN】畳み込み(Convolution)とは何か

前回はCNN(畳み込みニューラルネットワーク)が必要とされる背景として、DNNのデメリットを解説しました。今回は、そもそも畳み込みとは何なのかを解説します。

AI/データサイエンス

AI/データサイエンス  AI/データサイエンス

AI/データサイエンス  AI/データサイエンス

AI/データサイエンス  AI/データサイエンス

AI/データサイエンス  AI/データサイエンス

AI/データサイエンス  AI/データサイエンス

AI/データサイエンス  AI/データサイエンス

AI/データサイエンス  AI/データサイエンス

AI/データサイエンス  AI/データサイエンス

AI/データサイエンス  AI/データサイエンス

AI/データサイエンス