AI/データサイエンス

AI/データサイエンス 【ディープラーニング】Transformerとは何か – ChatGPTの元ネタを解説

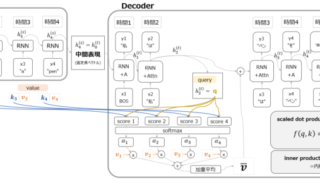

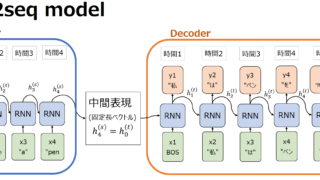

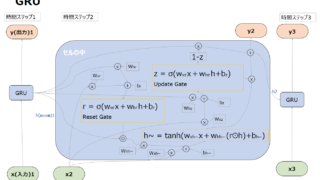

ChatGPTが世界中で話題になっています。ChatGPTの"GPT"はGenerative Pre-trained Transformerです。今回はChatGPTの元ネタであるTransformerについて解説します。

AI/データサイエンス

AI/データサイエンス  AI/データサイエンス

AI/データサイエンス  AI/データサイエンス

AI/データサイエンス  AI/データサイエンス

AI/データサイエンス  AI/データサイエンス

AI/データサイエンス  AI/データサイエンス

AI/データサイエンス  AI/データサイエンス

AI/データサイエンス  AI/データサイエンス

AI/データサイエンス  AI/データサイエンス

AI/データサイエンス  AI/データサイエンス

AI/データサイエンス