AI/データサイエンス

AI/データサイエンス 【機械学習】ロジスティック回帰とは何か

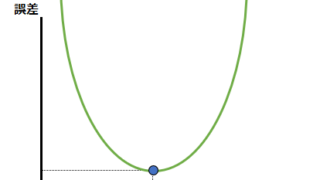

今回は機械学習の中の教師あり学習の分野における、ロジスティック回帰について解説します。ロジスティック回帰というのは、分類問題における確率を予測する統計手法です。分類問題には2値分類と多値分類がありますが、ロジスティック回帰は通常は2値分類に適用されます。2値分類というのは答えが2つの分類問題です。

AI/データサイエンス

AI/データサイエンス  AI/データサイエンス

AI/データサイエンス  AI/データサイエンス

AI/データサイエンス  AI/データサイエンス

AI/データサイエンス  AI/データサイエンス

AI/データサイエンス  AI/データサイエンス

AI/データサイエンス