過去にG検定では、様々なAIのモデルについて出題されています。今回はいくつかの視点に分けて、有名なAIのモデルについて紹介します。

IBM社のAI

Deep Blue

チェス専用スパコンのDeep thoughtの後継として1989年より開発を開始。1996年にチャンピオンに勝利した。アルゴリズムは計算量に任せた探索であった。

Watson

2011年にアメリカのクイズ番組Jeopardy!(ジェパディ)で歴代のチャンピオンに勝利した。アルゴリズムはWikipediaの情報を元にしたライトウェイト・オントロジー。当初は医療診断用途をターゲットに開発されたが、人材マッチング、広告、料理など多様な分野で活用されている。

オントロジーについては以下を参照ください。

囲碁・将棋のAI

AlphaGo

DeepMind社が外発した囲碁AI。CNN、強化学習、モンテカルロ法などを組み合わせたアルゴリズムを実装。2015年にプロ棋士に勝利した。

Ponanza

強化学習とディープラーニングを用いた将棋AI。2017年の電脳戦で名人に勝利した。

人口無能

人口無能とは、チャットボットのように、真に会話の内容を理解しているわけではなく、既定のルール・手順に従って処理するコンピュータプログラムのこと。

ELIZA

ELISAはMITのワイゼンバウムが1966年に開発したルールベースで動く初期のチャットボット(自然言語処理プログラム)。人口無能の起源となった。ワイゼンバウムは、一部のユーザーがELIZAが会話を理解できているわけではないことを理解せずにELIZAとの会話にのめり込んでしまう(イライザ効果)など反響の大きさに衝撃を受け、1979年にはコンピュータを万能と信じている人々に警鐘を鳴らす著書”Computer Power and Human Reason: From Judgment to Calculation”を書いている。

なお時代背景については以下を参照ください。

PARRY

ELIZAとともに有名な初期のルールベースチャットボット。1972年にスタンフォード大学の精神科医が開発。ICCC1972などでELIZAと会話したことがある。

Tay

2016年3月にマイクロソフトが発表したTwitter上のチャットボット。Twitterで多くの人とコミュニケーションがあったが、悪意あるユーザーが故意に差別的な発言や猥褻な発言を吹き込んだことで、すぐにアカウントが停止に追い込まれた。

イルダ

韓国のAIチャットボット。2020年12月にサービス開始したが、3週間程度で差別的な発言などを理由にサービスが停止された。

ILSVRCで脚光を浴びたモデル

ImageNetという物体認識研究用の大規模な画像データベースがあり、またImageNetプロジェクトとして2010年から2017年まで毎年画像認識のコンテストを開催した。それがILSVRC(the ImageNet Large Scale Visual Recognition Challenge)。

様々な画像認識の課題を出すが、最も有名なのは256×256画素の画像を1000通りに分類するというもの。1000通りの分類は人間でも見極めが困難な動物の種類の分類などが多く含まれている。以下のモデルもすべて、この課題において好成績を残し、最終的には人間のエラー率である4%をディープラーニングのモデルが凌駕した。

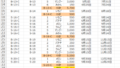

2012年 – AlexNet

2012年の優勝モデル。前年までの同課題における優勝モデルはSVMなどを用いており、誤答率は最高でも26%だったが、AlexNetは誤答率16%と、40%近くも精度を改善し、ディープラーニングモデルとして初めての優勝モデルになった。

AlexNetは当時の最新技術であったReLUやドロップアウトを採用し、GPUを2台使用した並列計算で大量の計算を可能として、8層のCNNを構築した。パラメータ6000万個。開発を主導したのがジェフリー・ヒントン。ジェフリー・ヒントンについては以下を参照ください。

混乱しやすいが、AlexNetはモデル名、チーム名としてはSuperVisionである。

2014年 – GoogLeNet

2014年の優勝モデル。誤答率は6.7%と、2012年優勝モデルのAlexNetから約2倍精度向上した。GoogLeNetの特徴はInceptionモジュールを用いた層が9つあること。GoogLeNetの主要研究者の提唱した”Network in Network”という考えに基づき、中間層の1つのInceptionモジュールの内側でも複雑なネットワークを構築した。

Inceptionモジュールの内側では、チャネル数の少ない1×1の畳み込み層を使ってパラメータ数を減らした上で、様々な大きさのカーネルで畳み込みを実行して様々な尺度で特徴量を抽出、それらを合体させるという処理をしている。これによって、相関しているニューロンを纏めることに成功した。

単純に1000種類の画像を認識できるような深層のモデルを構築しようとすると、スパースな状態になりパラメータ数が不要に増えてしまう。GoogLeNetはInceptionモジュールによってスパース(疎)な状態をデンス(密)に表現し、22層という当時としては非常に深いニューラルネットワークを実現することができた。

2014年 – VGG Net

2014年の優勝モデルはGoogLeNetで、その誤答率6.7%に対し、VGG Netは誤答率6.8%と惜しくも2位だったことで注目を集めたモデル。

GoogLeNetのInceptionモジュールのような斬新なアイディア無しにGoogLeNetと同等の精度を実現した。3×3の畳み込みを2回から4回連続するといった非常にシンプルな構造のため応用が利きやすく人気であり、よく用いられるモデル。GoogLeNetと同じく22層。

2015年 – ResNet

2015年に誤答率3.6%で優勝したモデル。152層という非常に深層にすることにより、前年のGoogLeNetから更に約2倍精度を向上させた。

Degradationという、浅いNNの方が汎化性能だけでなく訓練性能も良いという問題(理論的には深いNNほど少なくとも訓練性能は向上するはずなのに)を、Residual learningを導入することで解決し、層を圧倒的に深くしながら精度を向上させることができた。Residual learningというのは、全てのパラメータが0だった時に、出力を0にせず、出力が入力と同じになるような設計にすることで、層の途中で学習がほぼ完了している時に残りの層は前の層の値をそのまま使える(恒等写像)ようにする工夫のこと。

2017年 – SENet

ILSVRC最終回である2017年の優勝モデル。誤答率は2.25%だった。SEブロック(Squeeze and Excitation block)で、特徴量の圧縮(Squeeze)と興奮(Excitation)を行う。SEブロックでは、入力をGlobal Average Piiling(GAP)にかけた(圧縮)あと、ReLUとsigmoidを使って非線形化する。出てきた結果をもとの入力と掛けて出力とする。GAPでチャネルごとに情報を1次元に圧縮し、チャネルの特徴量を抽出している。また非線形化で最終的にsigmoidで0-1の値を出すことで、不要なチャネルは0がかけられて、必要なチャネルは1がかけられ、チャネルの取捨選択がされる。

コメント